Machine-Learning-fuer-Designer

Design für Machine Learning, Machine Learning für Design — einwöchiger Workshop an der Hochschule für Gestaltung Schwäbisch Gmünd, November 2018.

Durch Machine Learning (ML) lernen Computer, ohne explizit programmierte Regeln Muster in Daten zu erkennen. Die Technologie steuert autonome Fahrzeuge und Netflix-Empfehlungen, erkennt Kätzchen und Gesichter, wie wir dastehen und auf was wir stehen, Alexa spricht, Siri hört zu.

Für Gestalter öffnen sich aufregende Möglichkeiten — individuelle User Experiences, neuartige Interfaces, der Computer als kreativer Assistent, smarte Designtools.

Was ist ML und was nicht? Wie können wir Machine Learning in unseren Projekten einsetzen, wie im Designprozess selbst? Wie gestalten wir verantwortungsvoll mit einer Technologie an der Spitze des Hype Cycle? Ziel des Workshops ist es, verschiedene ML Anwendungsbereiche kennenzulernen und in eigenen Projekten prototypisch anzuwenden (ohne dabei Hype und Mythos zu verfallen).

von Philipp Schmitt. Stand: November 2018.

Einführung: Machine Learning für Designer

- Grundlagen

- Was ist ML? Beispiele, Definition und ein Ausflug in die Mathematik

- Arten von ML: Supervised, Unsupervised, Reinforcement Learning

- Von Neural Networks zu Deep Learning: Geschichte und Grundlagen

- Rezept für ein ML-Projekt: Begriffe, Zutaten, Ablauf

- Gestaltung mit ML

- Notwendigkeit und Machbarkeit

- Kontrolle und Transparenz

- Umgang mit Unsicherheit

- Bias & Ethik

- Hype und Mythos

- Projekt-Showcase

- Werkzeuge und Ressourcen

Links / Quellen

Eine Liste von Ressourcen, die ich persönlich nützlich finde. Nicht als vollständige Referenz zu sehen, sondern als Einstieg.

Technologie

Tutorials, Bücher, Artikel, …

- Eine visuelle Einführung ins Maschinelle Lernen

- Machine Learning for Artists (ml4a), insb. The Neural Aesthetic

- “The Coding Train”, z.B. A Beginner’s Guide to Machine Learning with ml5.js

- Machine Learning is Fun

- ML Glossary

- Introduction to machine learning, Ethem Alpaydin

Tools

- Wekinator

- Runway

- ml5.js

- Brain.js

- Google Cloud AI, z.B. Vision API

- Clarifai

- Microsoft Cognitive Services

- scikit-learn

- AutoML

Design

- The UX of AI

- The Intelligence Augmentation Design Toolkit

- Machine Learning for Designers

- What designers need to know about machine learning, Emma Rosenberg

- The Designer’s Guide to Machine Learning, Cris Christina

- Applications Of Machine Learning For Designers, Lassi A Liikkanen

- Algorithm-Driven Design: How Artificial Intelligence Is Changing Design, Yury Vetrov

- Experience Design in the Machine Learning Era, Fabien Girardin

- AI UX: 7 Principles of Designing Good AI Products, Dávid Pásztor

- Human-Centered Machine Learning, Josh Lovejoy and Jess Holbrook

- Machine Learning and User Experience: A Few Resources, Michelle Carney

Philosophie, Geschichte, Ethik, …

- Machines that Morph Logic: Neural Networks and the Distorted Automation of Intelligence as Statistical Inference, Matteo Pasquinelli

- How To Recognize Exclusion in AI, Chou et al.

- Everyday Ethics for Artificial Intelligence

- It’s ML, not magic: simple questions you should ask to help reduce AI hype, Smerity

- AINow Institute Symposium 2018

- Data & Society

- The Man Who Tried to Redeem the World with Logic, Amanda Gefter

- The Great A.I. Awakening, Gideon Lewis-Kraus

Showcase

Studenten-Projekte

Widerstandssortierer

Widerstand einwerfen, Ohmzahl ablesen, fertig. Michelle Bauch und Aaron Eichler haben mit Wekinator ein Model trainiert dass elektronische Widerstände anhand ihres Farbcodes erkennt.

Widerstand einwerfen, Ohmzahl ablesen, fertig. Michelle Bauch und Aaron Eichler haben mit Wekinator ein Model trainiert dass elektronische Widerstände anhand ihres Farbcodes erkennt.

NeuraLorem

NeuraLorem von Sven Löchner ist ein Plugin für Sketch zur Erstellung von Lorem Ipsum Fülltext. Das Plugin generiert den Text basierend auf der Eingabewörter und versucht, anstelle des Standard Lorem Ipsum Fülltextes einen kontextbasierten Fülltext zu erstellen. Das Projekt basiert auf minimaxir/textgenrnn, einem Neural Network zur Textgenerierung.

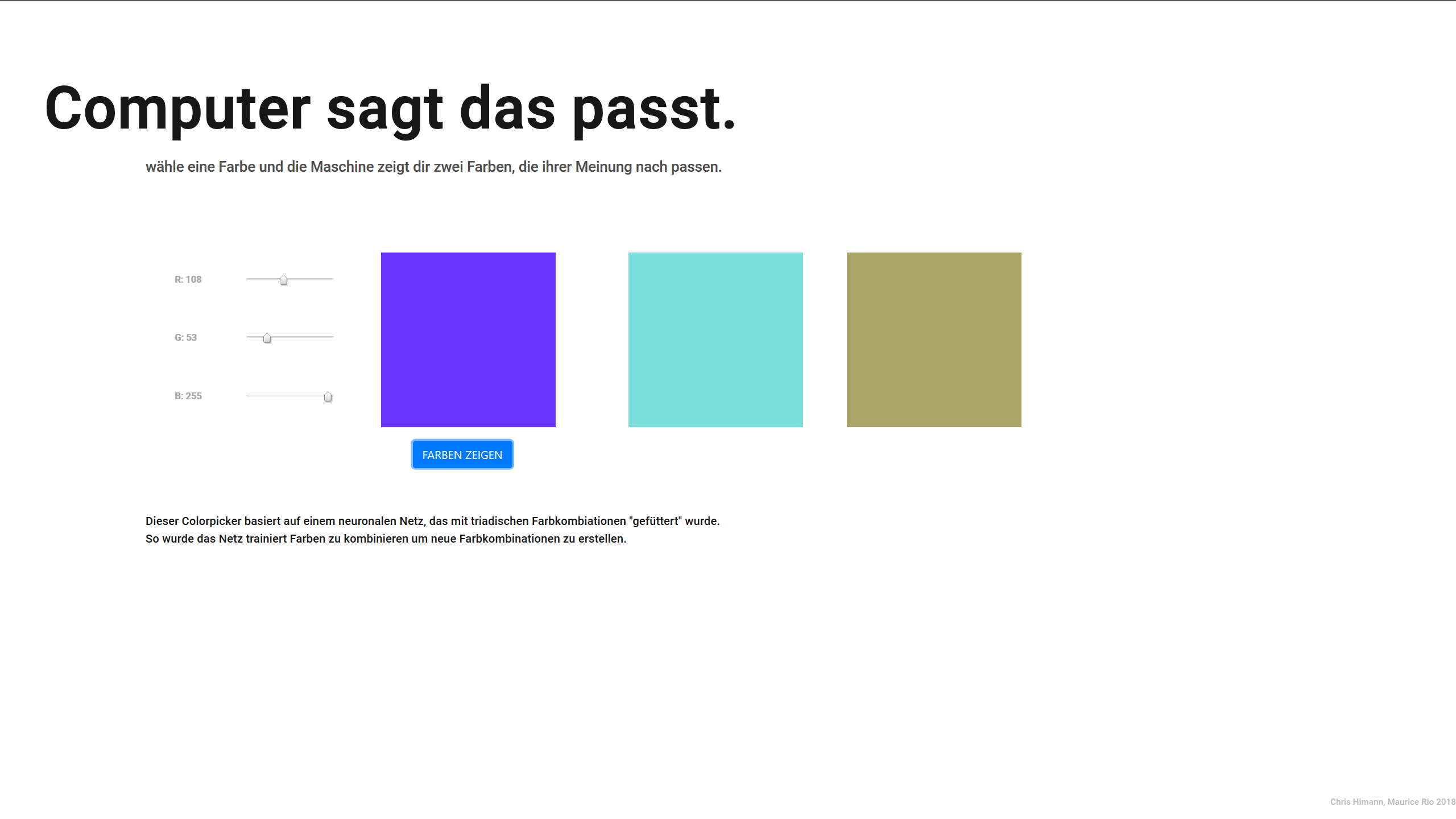

ML Colorpicker

Christopher Himann und Maurice Rio haben einen ML Color Picker entwickelt. Der Benutzer wählt eine Farbe aus und ein Neurales Netzwerk ergänzt zwei weitere. Der ML Color Picker basiert auf brain.js und wurde mit Farbharmonien trainiert.

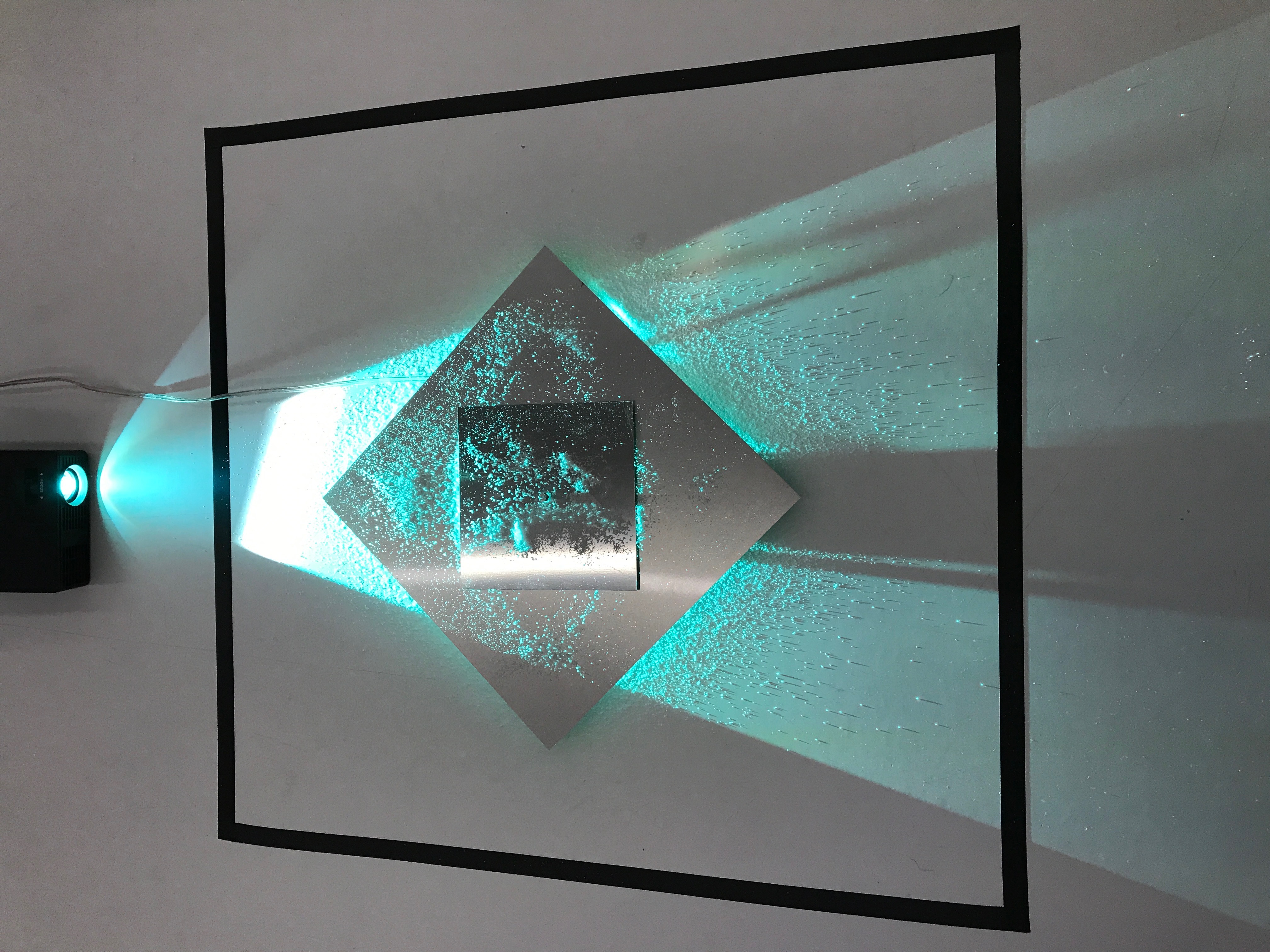

(Un)Sichtbare Emotionen

(Un)Sichtbare Emotionen, von Maximilian Härle und Tobias Haag, erkennt per Webcam Gesichtsaustrücke, versucht Emotionen zu erkennen und setzt die Daten in Farben und Frequenzmuster aus Salzkristallen um. Das räumlich-visuelle Konzept hat die Absicht, dass eine Person vor dem Screen steht und die zum Gesichtsausdruck verbundene Farbe wahrnimmt und eine andere Person das „Emotionsmuster“ erkennt.

Pixelsound

![]()

Pixelsound von Laura Humpfer und Monika Litzinger verwandelt mit Hilfe von Wekinator visuellen Input in auditiven Output.

@therealdonaldtrump Tweet Map

Florian Deitermann, Janis Walser-Cofalka und Max Mertens haben mit Hilfe von t-SNE, Bag-of-Words und p5.js Tweets des US-Präsidenten visualisiert, um Rhetorik visuell erkenntlich zu machen.

Visualizing how the machine learns

Datenkunst mit t-SNE von Florian Deitermann, Janis Walser-Cofalka und Max Mertens.

Handschrift-Erkennung

Valerie Grappendorf hat mit Wekinator und Processing eine Handschrift-Erkennung programmiert.

Herzlichen Dank an die motivierten Studenten, die HfG Schwäbisch Gmünd sowie an die zahlreichen Autoren von Open-Source Tools und Lernmaterialien, auf denen dieser Workshop basiert!